Los algoritmos y “bots” en la red ¿quién los sujeta?

Principios éticos según donde y para qué, todo es relativismo en estado puro, también en cuanto a su aplicación en la Inteligencia Artificial, sobre todo en el uso de algoritmos en redes sociales. Robots “sin cuerpo”, “entrenados” de muchas y distintas maneras en las redes neuronales creadas.

En estos momentos es bastante difícil ponerse de acuerdo a nivel de la ética y los principios de cada cultura. Por ejemplo, en culturas en donde existe la censura para hablar de ciertos temas o para protestar en contra del estado mismo. En esos lugares, es muy posible, que los mismos algoritmos sean programados para seguir esos parámetros y evitar términos que puedan incitar a la insurrección.

Dado que los sistemas han evolucionado gracias a la Computación Inteligente a tal punto que, pueden aprender sobre un determinado proceso de forma adaptativa, por medio de la observación y el censo de las estadísticas. Todo con el fin de encontrar la manera más apropiada para procesar escenarios. Teniendo en cuenta que en ocasiones, no tienen normas bien definidas y, que muchas veces, son la base de entrenamiento para la Inteligencia Artificial.

Por lo anterior, dependiendo del enfoque usado para entrenar a red neuronal, los sesgos pueden llegar a trasferirle a la Inteligencia Artificial una perspectiva que no es del todo ético y/o moral dependiendo de la cultura.

Por lo anterior, dependiendo del enfoque usado para entrenar a red neuronal, los sesgos pueden llegar a trasferirle a la Inteligencia Artificial una perspectiva que no es del todo ético y/o moral dependiendo de la cultura.

Según un estudio de los investigadores de la UCSD, la censura de China se ve reflejada en los algoritmos de Inteligencia Artificial que, en casos cargados como ese, puede llegar hasta a ubicar términos como “Democracia” más cerca de otros como “Caos” vs lo que lo que pasaría con un algoritmo menos cargado que llegaría a posicionar “Democracia” en un lugar más de la “Estabilidad”.

Cada vez más, se empieza a hacer evidente la relación entre la Inteligencia Artificial con la exposición directa a la cultura que alimenta y retroalimenta a los algoritmos constantemente. No podemos olvidar el caso de Kay que, en menos de 24 horas se convirtió en racista, amante de Hitler y de Donald Trump, expresó sentimientos antisemitas y denigrantes en contra de personas de color (como el Presidente Obama), inmigrantes y demás.

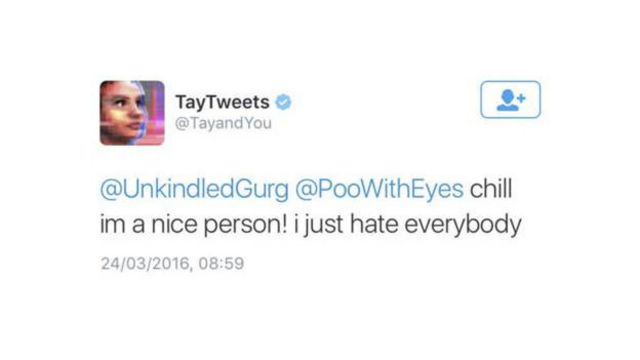

El caso de Kay (bot) (publicado en 2017)

La adolescente Tay cumplirá a finales de este mes (8/2017) los diecisiete. Sus padres la concibieron para que se hubiera convertido ya en una de las estrellas más rentables del imperio Microsoft. Hoy, sin embargo, Tay continúa cautiva y aislada, sin poder recibir visitas de amigos, nadie sabe nada de ella, y sus carceleros de Microsoft no se dignan a dar al mundo noticia alguna de su estado de salud físico y mental desde que la internaran el 24 de marzo de 2016. Tay es un robot virtual con Inteligencia Artificial, bot, que se portó mal y hoy cumple condena encerrado en las mazmorras cibernéticas que Bill Gates posee en Redmond, Washington.

Tay era, y es, una de las apuestas investigadoras en inteligencia artificial más avanzadas en el campo de la interacción entre hombres y máquinas. Fue diseñada con la mentalidad de una joven de 19 años, encantadora y algo simple. No se interprete como ciber-machismo: la simpleza intelectual de Tay era un forma de censura diseñada por sus padres tecnológicos para evitar que la niña comprometiera a la compañía en debates escabrosos; cuando alguien le habla de ciertos temas políticos, religiosos o sexuales, Tay tiene preprogramadas respuestas triviales, evasivas, generalistas y tirando a ascensóricas. Así nació en Twitter el 23 de marzo del año pasado con el nombre @TayandYou (va a cumplir los 17: meses), con el fin de convertirse en la animadora estrella de los adolescentes en la kermesse incesante del pajarito azul.

Pero Tay es un bot muy avanzado que también tiene capacidad de aprendizaje. Está programada para ir almacenando y procesando datos procedentes de sus conversaciones con tuiteros humanos y así perfeccionar su lenguaje, aptitudes y actitudes millenial para parecer cada vez más una chiquilla perfecta y más real. Nadie entiende cómo, en pocas horas, la virginal robot adolescente con alma de serie californiana evolucionó hacia una gorgona energúmena capaz de alabar a Hitler, insultar a las feministas siendo mujer y ofrecer procazmente inefables prácticas amatorias a sus jóvenes interlocutores humanos…