Consecuencias geopolíticas del final de la ley de Moore en los chips: Solo unos pocos pueden permitírselo

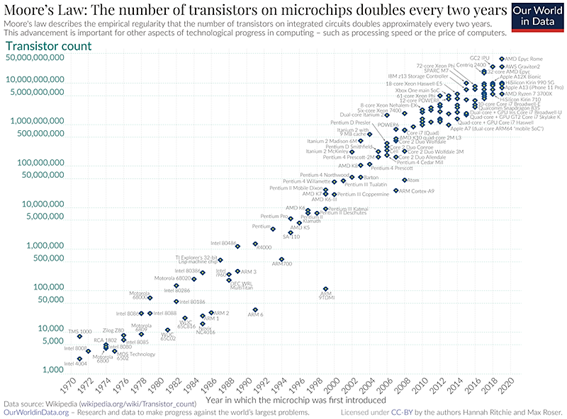

El microprocesador moderno se encuentra entre los sistemas más complejos del mundo, pero en el fondo está constituido por dispositivos que conocemos bien desde hace más de 75 años: el transistor. Hoy en día hay miles de millones de ellos en un microprocesador y casi todos son idénticos. Por lo tanto, mejorar su rendimiento y aumentar la densidad de estos transistores es la forma más sencilla de hacer que los microprocesadores y los ordenadores que alimentan funcionen mejor. En esencia, esa es la premisa que está detrás de la Ley de Moore, incluso ahora que parece estar llegando a su final (yo sería muy cauto con los finales, nos dijeron a comienzos de 1980 que el silicio había llegado a su límite…y ahí sigue).

En 1965, el cofundador de Intel, Gordon Moore, predijo que el número de transistores en un chip se duplicaría aproximadamente cada dos años, con un aumento mínimo en el costo.

Uno de los problemas que presenta los tamaños tan reducidos que tienen los transistores de ese y otros circuitos equivalentes fabricados en el nodo de 5 nm es que las capacidades del transistor se encuentran auténticamente al límite, unido a algo que es evidente: el escalado no puede continuar para siempre porque los transistores los podemos seguir reduciendo de tamaño, pero hay un límite obvio ¡no pueden ser más pequeños que un átomo! Aparecen los efectos cuánticos…que es una barrera en la actualidad, pero puede ser una oportunidad en el futuro.

Este problema que limita el crecimiento de la ley de Moore tiene una consecuencia inmediata.

Para aumentar la capacidad de computación (sin reducir el tamaño de los chip) se necesita más tamaño de instalación, más energía y más refrigeración. Aunque están apareciendo nuevas arquitecturas de microchips que aprovechan mejor el espacio físico empleado y se aproximan a apenas unos pocos nanómetros.

El GAAFET (Gate All Around FET o Transistor de Efecto Campo de Puerta Perimetral o “todo alrededor”), que también se denomina MBCFET (Multi-Bridge Channel FET o Transistor de Efecto Campo de Puerta Múltiple), quizá se convierta en la evolución natural del FinFET [la evolución actual del MOSFET y el dispositivo principal en los chips de los nodos inferiores a 16 nm] y tal vez, serán los dispositivos clave de los chips del inmediato futuro, ya que prometen mayor rendimiento, menor consumo y menos fugas que las que tiene el FinFET. Su diferencia esencial con el FinFET estriba en la posibilidad de transportar más corriente sin aumentar el tamaño del dispositivo y, lo que es crucial, manteniendo reducida su huella en el chip.

Pasar a cualquier nueva tecnología de transistores es un desafío, y el programa de introducción del GAAFET en los chips de vanguardia varía según la empresa que se plantea fabricarlo. Por ejemplo, Samsung está utilizando varios procesos basados en FinFET en los nodos de 7 nm y 5 nm, mientras que ya ha introducido el GAAFET para los chips del nodo de 3 nm en este año. TSMC extenderá el FinFET en sus chips de 3 nm, pero migrará a GAAFET en el nodo de 2 nm en 2024/2025. Intel y otros también están trabajando en GAAFET, pero no hay fecha definida de comercialización, aunque no se debería demorar mucho.

Límites físicos

Además del propio tamaño de los transistores, cada vez más cerca del tamaño de los átomos, en el mundo de lo cada vez más pequeño surgen otros inconvenientes. Uno es la aparición de efectos cuánticos: la materia a pequeña escala se rige por otras leyes, ahí abajo es bastante probable que una partícula atraviese una barrera de potencial. Sería lo equivalente a que en nuestro mundo una pelota atravesase un muro. Se llama efecto túnel y es una de las extrañas cualidades de lo cuántico. “Con el efecto túnel la corriente empieza a tener menos precisión y los umbrales de funcionamiento empiezan a ser peores”

La gran pregunta es cuántas empresas serán capaces de financiar, fabricar y comercializar de manera rentable esta continua reducción de dimensiones. Uno de los responsables de UMC, la otra gran compañía taiwanesa de fabricación de chips, dijo no hace mucho: “Realmente se trata de la economía de la muerte. En los nodos de vanguardia, los costes de las obleas son astronómicos, por lo que muy pocos clientes y muy pocas aplicaciones pueden permitirse aprovechar de manera rentable esta tecnología“.

La computación cuántica

Pero la vía que parece que supondrá un cambio cualitativo es la computación cuántica. En esta disciplina los estados posibles no son solo el 0 y el 1, sino una superposición de ambos estados, como en el famoso caso del gato de Schrödinger que está muerto y vivo al mismo tiempo. Así, del bit tradicional, pasamos al qubit. La capacidad de computación crecería de tal manera que todavía es difícil imaginar sus consecuencias. Por lo pronto uno de los efectos más señalados es que un ordenador cuántico podría volar por los aires todos los sistemas de encriptado, por ejemplo el de las tarjetas de crédito. “Para encriptar una tarjeta de crédito hay, básicamente, que descomponer en dos factores un número muy grande. Es una operación que a un ordenador normal le podría llevar miles de años, pero que un ordenador cuántico podría realizar en un tiempo razonable”, explica Joaquín Fernández Rossier, investigador en nanoelectrónica en la Universidad de Alicante y en el International Iberian Nanotechnology Laboratory (INL). “Pero no va a ser más rápido enfrentando problemas normales”, añade, “sino que van a poder resolver de forma eficiente que lo ordenadores normales no pueden resolver”.